TECH BLOG

「ChatGPTの次」は何が来るのか?——各社レポートから読み解くエージェント型AIへのシフトとビジネス戦略

こんにちは、ARISE analyticsでデータ分析支援業務を中心に行う「データコンサルタント」というキャリアトラックに所属している徳元です。現在、AIを用いたアプリケーション開発に携わっております。

近年、AI分野の目まぐるしい発展が度々ニュースになっていますが、企業のAI活用という側面では「ChatGPT導入」が一巡し、多くの企業で「次はどうする?」という議論が起きているかと思います。

そんな中、ビッグテックや研究機関が口を揃えて提唱しているのがエージェント型AIへのシフトです。

「Microsoft CopilotやOpenAIのツールを使えばいいのでは? なぜわざわざ開発するのか?」という議論もありますが、実際にビジネス価値を生むには、単なるツール導入ではなく、自社のワークフローに深く組み込まれたエージェントの設計が不可欠になりつつあります。

本記事では、前半でGartnerやAndrew Ng氏らが提唱する最新の技術トレンドを整理しつつ、McKinseyやAccentureなどのエージェント型AI分野に関するレポートについて紹介したいと思います。

1. トレンド:AIは「Chat(対話)」から「Agent(行動)」へ

これまでの生成AI活用は「人間が質問し、AIが答える」という対話(Chat)が中心でした。しかし2025年以降のトレンドは、AIが自律的にツールを使いこなし、タスクを完遂する行動(Action)へと移行しています。

Gartner: 2025年の戦略的トップトレンド

Gartnerは「2025年の戦略的テクノロジートップトレンド」の筆頭にエージェント型AIを挙げています。

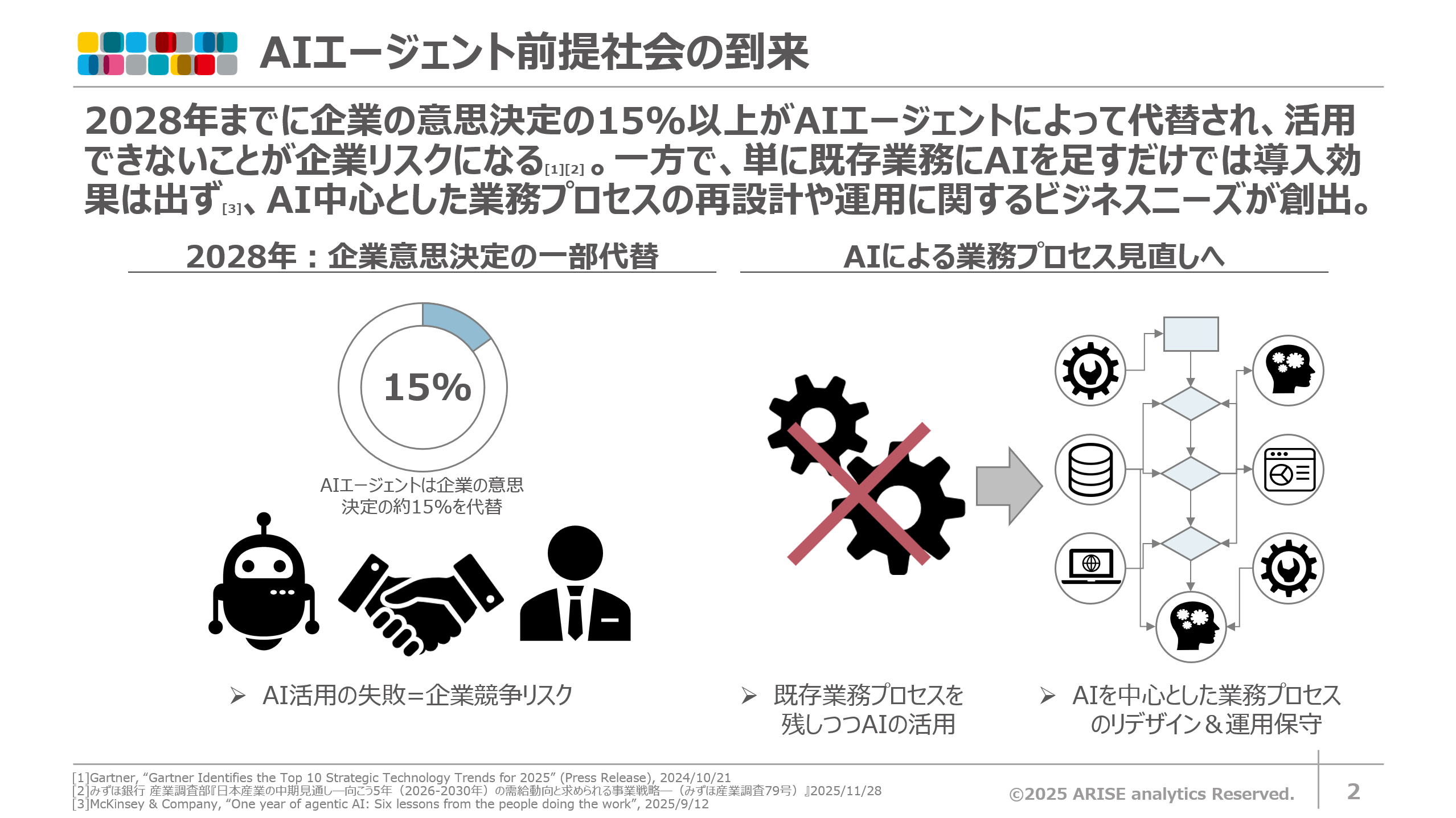

予測によれば、2028年までに企業の業務意思決定の少なくとも15%がエージェント型AIによって自律的に行われるようになるとされています。これは現在のチャットボットによる支援とは次元の異なる変化になると想定されます。

Anthropic: "Computer Use" の衝撃

このトレンドを技術的に裏付けるのが、2024年10月にAnthropicが提供し、広く注目を集めたClaude 3.5 SonnetのComputer Use(ベータ版)機能です。

AIがAPIを叩くだけでなく、「人間のように画面を見て、カーソルを動かし、クリックし、入力する」ことが可能になりました。

現在でもComputer Use関連の技術開発が進んでおり、精度も着実に上がっていることを踏まえると、レガシーシステムを含むあらゆるアプリケーションをAIが操作できる未来を示唆しています。

Andrew Ng氏の提言:モデル性能より「ワークフロー」

参考記事: Andrew Ng: Why Agentic AI is the smart bet for most enterprises

Unless a company has “an extra few billion dollars to spare,” the priority should be on building practical applications through agentic workloads.

とあるように、AI研究の第一人者 Andrew Ng 氏は、「企業が「数十億ドルの余裕」がない限り、優先すべきはエージェントワークロードによる実用的なアプリケーションの構築」であるとの提言をされています。

高性能モデル単体に依存するよりも、比較的軽量なモデルでも Planning・Tool Use・Multi-Agent といったワークフロー設計を行うことで、タスクによっては GPT-4(ゼロショット)以上の実用的成果を得られる可能性があると論じられています。

つまり、これからの競争優位は、「単体のLLM性能(Model)」ではなく、「LLMをどのように組み合わせ(Workflow)、成果物の精度を高めるか」というプロセス設計に移りつつあることを示しています。

これらの情報源はいずれも 2024年の時点での記事ですが、最新動向と照らしても本質的な潮流は変わっておらず、違和感のない知見として活用できると個人的には考えております。

2. McKinseyレポート:開発現場からの6つの教訓

ここからは、McKinseyのAI部門であるQuantumBlackが、50以上のエージェント型AIプロジェクトを通じて得た「現場の教訓(Lessons Learned)」を紹介します。

参考記事: One year of agentic AI: Six lessons from the people doing the work

Lesson 1: エージェントではなく「ワークフロー」を見るべき

(It’s not about the agent; it’s about the workflow)

多くのプロジェクトが「素晴らしいエージェント型AI」を作ることに注力しすぎて失敗しています。成功の鍵は、エージェント単体の性能ではなく、ワークフロー全体(人、プロセス、技術)の再設計にあります。

レポートでは、法を扱う業務事例が紹介されていましたが、単にLLMに答えさせるのではなく、「エディタでのユーザーの修正履歴」をログとして収集し、それをフィードバックループとしてエージェントを賢くするシステムを構築していました。

「エージェントをどう作るか」より「エージェントをプロセスのどこに配置し、どうデータを還流させるか」が重要になってくるとのことです。

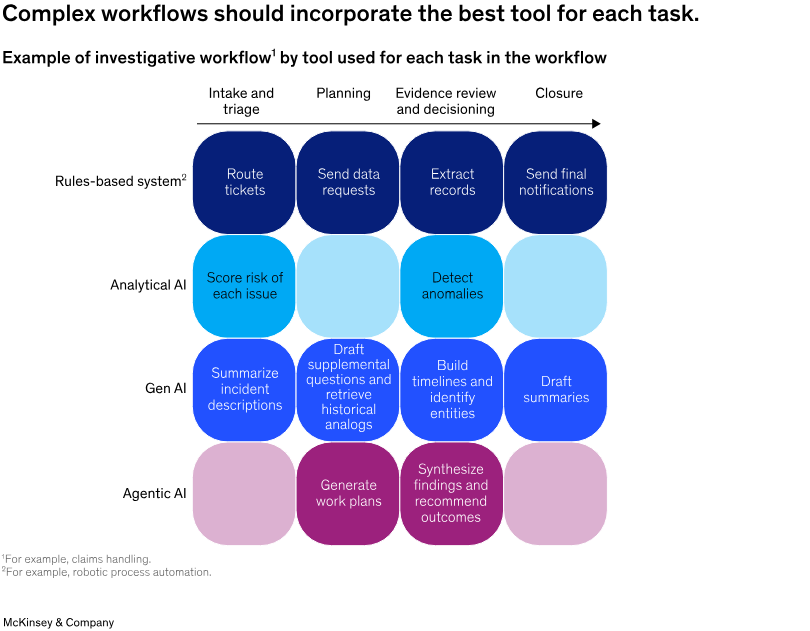

エージェント型AIが実際の業務プロセスの中で担えるタスク領域を階層構造で整理した図であり、エージェント型AIの価値は単純自動化ではなく、業務計画の生成、考察の統合、改善提案や意思決定の推奨など、複雑業務の分解と高度意思決定支援にあることを示しています。

Lesson 2: エージェントが常に正解ではない

(Agents aren’t always the answer)

「なんでもエージェント」はアンチパターンです。McKinseyのレポートでは以下のような技術選定基準を提案しています。

- ルールベースで済むならそれが一番(低コスト・確実・高速)

- 従来の予測AI(ML)でいいならそれを使う

- エージェント型AIは、複雑で変動性が高いタスク(High-variance, low-standardization)にこそ適している

エンジニアは「技術選定」の責任を持ち、流行りであってもエージェントを使わない勇気を持つ必要があります。

|

タスクの特徴 |

推奨されるAI技術 |

説明 |

|---|---|---|

|

ルールベースで反復的(例:入力が構造化、データ入力・転記) |

ルールベース自動化(RPA) |

条件が明確で変動が少ないため、AIよりRPAの方が安定・高速・低コスト。 |

|

入力が非構造化(例:長文ドキュメント、報告書、メール等)かつ抽出/生成が中心 |

生成AI(LLM)/NLP/予測分析 |

テキスト理解・要約・抽出・生成を行うため、LLMやNLPが最適。 |

|

過去データから分類・予測したい |

予測分析(MLモデル)/生成AI |

教師あり学習による分類・回帰タスクに最適。 |

|

出力に統合、判断、創造的解釈が必要 |

生成AI(LLM) |

推論力・統合力・クリエイティブ性が必要なタスク向け。 |

|

入力が多様で変動が大きい/マルチステップの意思決定が必要 |

AIエージェント(エージェント型AI) |

タスクに複数段階の意思決定が含まれ、非常に変動しやすい入力とコンテキストが長く続く複雑タスクで最大効果。 |

Lesson 3: "AI Slop"を回避せよ(Evalsへの投資)

(Stop ‘AI slop’: Invest in evaluations and build trust with users)

デモでは動くが、実務で使うと微妙な出力(AI Slop = AIが吐き出す低品質なアウトプット)を出し続け、ユーザーの信頼を失うケースが多発しています。

これを防ぐには、従業員教育と同じくらい「エージェントの教育(評価)」に投資する必要があります。

- Evals(評価基盤)の構築: F1スコア、意味的類似度(Semantic similarity)、LLM-as-a-Judgeなど、タスクに応じた定量的な評価指標を確立する。

- Gold Standard: 専門家による「正解データ」の作成をサボらない。

Lesson 4: 全ステップを追跡・検証可能にせよ

(Make it easy to track and verify every step)

エージェントが数百、数千にスケールすると、「どこで間違えたか」が追えなくなります。

エンドツーエンドの結果(出力)だけでなく、思考の各ステップ(Chain of Thought)やツール呼び出しのログを取得し、オブザーバビリティ(可観測性)を確保する必要があります。

ある事例では、急に精度が落ちた原因が「特定のユーザー層が低品質なデータを入力し始めたこと」だと突き止めましたが、これは詳細なステップ追跡があったからこそ可能だったとのこと。

Lesson 5: 「再利用」こそが最高のユースケース

(The best use case is the reuse case)

エージェント型AIの発展を急ぐあまり、企業は特定のタスクごとに個別のエージェントを作成することがよくあります。

ただし、タスクごとに専用エージェントをゼロから作ると、大きな冗長性と無駄につながる可能性があり、最悪の場合メンテナンス不能になります。

再利用可能なエージェント(特定のタスクのみを実行するエージェントではなく)の構築にどれだけの投資を行うかは、企業が迅速に構築する必要がある一方で、将来の機能を制約するような選択肢を固定化しない方針をとることは重要です。

「情報の抽出」「検索」「分析」といった共通のアクションをコンポーネント化し、機能を単一のプラットフォームに統合することで開発コストを大きく削減することが可能です。

Lesson 6: 人間は依然として不可欠(役割は変わる)

(Humans remain essential, but their roles and numbers will change)

完全自律型はまだ先の話です。人間は「監督者」「コンプライアンスチェッカー」「エッジケースの対応者」として不可欠です。

UI/UXの観点でも、人間がエージェントの出力を検証しやすいインターフェース(該当箇所へのハイライトや自動スクロールなど)を提供することで、受容率が劇的に向上します。

3. McKinseyレポート:AI導入の現在地 (State of AI 2025)

同じくMcKinsey社からのレポートになります。

参考記事: The state of AI in 2025

エージェント型AIはまだ「実験中」が多数

- 回答企業の62%がエージェント型AIを実験中。

- しかし、スケーリング(全社展開)できているのは23%に留まる。

- 多くの企業が「パイロットの壁」に直面しているのが現実です。

下記図は「AI技術(機械学習・GenAI・AIエージェント)が、どの業務領域でどれほどの価値を生んでいるか」 をテーマ別に比較した図です。.png?width=810&height=1018&name=image-20260119-114425%20(1).png) 活用状況としては、ITおよびナレッジマネジメント分野において最も多く報告されており、ITにおけるサービスデスク管理やナレッジマネジメントにおけるディープリサーチといった事例が多いです。

活用状況としては、ITおよびナレッジマネジメント分野において最も多く報告されており、ITにおけるサービスデスク管理やナレッジマネジメントにおけるディープリサーチといった事例が多いです。

業種別では、AIエージェントの利用が最も多く報告されているのは、テクノロジー、メディア・通信、ヘルスケアの各セクターが報告されています。

High Performers(成果を出している企業)の特徴

AI導入で実際に大きな価値(EBITへのインパクト)を出している企業には共通点があります。

- イノベーション志向: 単なるコスト削減(効率化)だけでなく、新規事業や成長のためにAIを使っている。

- ワークフローの再設計: 既存プロセスにAIを足すだけでなく、プロセス自体を根本的に作り変えている。

- 使いっぱなし”にしない運用設計: 出力の検証、例外処理、人間の介在ルールなどを体系的に整え、AIを業務に組み込む仕組みを確立している。

4. Accentureレポート:2025年の4つのトレンド

次はアクセンチュアのレポートについて紹介します。

より俯瞰的なAI活用に関する分析レポートになっている印象で、両方合わせて読むことでより解像度が高まると思います。

参考記事:

導入

AIエージェントは「記憶・計算・予測」まで担える水準に達しつつあります。一方、企業内での普及は限定的です。主要因としては、予測や意思決定がルールとして既存システムに固定化されており、AIに予測を委託しにくい点にあります。企業がAIに委託していけるように変革するにはAIへの理解と信頼が必要で、4つのトレンドを次に紹介します。

バイナリ・ビッグバン(Binary Big Bang)

AIと人が協力することで莫大なデータとプロセスが生まれ、システム開発のあり方が一変する現象です。

- 開発の民主化と高速化: AIエージェントを前提とした時代に入り、新たに導入されるコードの25%以上をAIが生成する企業も登場しています。

- バイブコーディング(Vibe Coding): 開発者がAIエージェントと対話しながらコードを磨き上げる手法により、生産性と品質が劇的に向上します。

- 技術基盤: Anthropicが提唱した**MCP(Model Context Protocol)**などが普及し、AIが既存システムやデータにシームレスにアクセスできる環境が整いつつあります。

これらの流れから、プログラムやアプリ開発が、エンジニア以外の人も可能になると、ワンタイム・プログラムを短時間に作って活用するようになり、バイナリーデータの生成が加速度的に進む「バイナリ・ビッグバン」が起こります。

一方で、質の悪い学習データによるデータ汚染や、高度なAIによる不正など、悪影響も示唆されています。企業は、それらの特性を理解した上で高品質な学習データの確保やAIへのルール適用などの取り組みによりAIへの信頼を構築することが重要です。

未来の顔(Your Face, in the Future)

AIエージェントが顧客接点の中心となり、ブランドの「擬人化」が差別化の鍵となる時代です。

- パーソナライズコミュニケーション: マス広告から、AIエージェントによる1対1の自律的なコミュニケーションへと移行します。

- ブランド人格の重要性: 汎用的なAIモデルは「当たり障りのない」体験になりがちです。企業は独自の価値観や人格をAIに組み込み、「擬人化したビジネス」を構築する必要があります。

- エージェント同士のやり取り: ユーザー個人もAIエージェントを持つようになり、企業のエージェントと顧客のエージェントが自律的に情報を交換するエコシステムが形成されます。

これらの動きからも今後は自社のAIエージェントを通じて顧客データを収集し、パーソナライズされたサービスを提供する「独自路線」と、他社のAIエージェントとの協力を重視する「コラボ路線」の両立が求められていくことが予想されます。

LLMが体を持つ時(When LLMs get their Bodies)

大規模言語モデル(LLM)とロボティクスの融合により、物理世界で自律的に動くロボットが登場する転換期です。

- 推論するロボット: 従来の「決められた動作を繰り返す」ロボットから、LLMや視覚言語モデル(VLM)を活用して「文脈を理解し、考えて動く」多用途なマシンへ変貌します。

- 人間社会への溶け込み: 物理法則や空間、人間との対話を理解することで、工場内だけでなく、店舗や家庭などの予測不能な環境での活躍が期待されます。

- RaaS(Robotics-as-a-Service): 汎用的な機体とソフトウェアの登場により、ハードウェアを所有せず、必要な時だけ借りて実験・導入するビジネスモデルも加速します。

人間らしいロボットが誕生した際には、ロボットにより集合知化されたデータやプライバシーをどのように管理していくのか、倫理やセキュリティ面の整備は不十分で、整理に向けた議論が急務です。

新たな学習サイクル(The New Learning Loop)

AIと人間が互いに学び合い、共に進化する好循環(フィードバックループ)を指します。

- スキルの流動化: AIが無限のスキルを補完するため、特定の専門知識以上に、企業の価値観へのマッチ度や、AIを使いこなして仕事を変えられる柔軟性が求められます。

- ボトムアップの変革: 従来のトップダウンな導入ではなく、現場の従業員がAIを使って自発的にアプリを開発したり、業務を効率化したりする環境を整えることが重要です。

- エンゲージメントの維持: 単なる「人間の代替(自動化)」ではなく、人間がより創造的な仕事に集中できる「自律性の拡張」としてAIを位置づけることが、信頼構築の要となります。

AIと相互学習を実現するためには人に求められるスキルも変わり、企業の価値観や行動基準とのマッチ度や継続的にAIで学習し仕事の仕方を変えられる柔軟性、AIエージェント含め組織を超えた協創的なコミュニケーションができるスキルが求められます。

5. さいごに

今回紹介したGartnerのレポートでは、「2028年までに企業の業務意思決定の15%がエージェント型AIに代替される」という信じがたい予想も出ていました。日本産業においてもみずほ産業調査にて「AI・テクノロジー活用、 DXの遅れによる競争力の低下」がリスク候補の一つとして挙げられており、AIを事業に活用できないことが企業リスクになる未来が様々な角度から提言されています。

参考記事: みずほ銀行 産業調査部『日本産業の中期見通し―向こう5年(2026-2030年)の需給動向と求められる事業戦略―(みずほ産業調査79号)』2025/11/28

エージェント型AIは業務自動化に貢献できる技術として注目されていますが、導入を考える際には、既存業務にAIを足すだけでは導入効果は出ないことも推測されるため、AI中心とした業務プロセスの再設計や運用に関する社会的ニーズが新たに生まれてくることがMcKinseyのレポートから予見されます。

そういった業界変化の中で、例えば我々のようなAIコンサル企業やその所属エンジニアの役割も以下の様に変わってくるのではないでしょうか。

① 「Evals(評価)」駆動開発へのシフト

プロンプトエンジニアリングで「なんとなくいい感じ」にする時代は終わり、ソフトウェアテストと同じように、テストセットを作り、定量的に評価するパイプライン(CI/CD for AI)を構築するスキルが必須に。

② プロンプト力よりもシステム設計力

エージェント単体の賢さよりも、前後のデータフロー、人間による確認フロー(Human-in-the-loop)、ログ基盤、エラーハンドリングといった「システム全体のアーキテクチャ設計」が価値の源泉に。LLMはあくまで「部品」の一つとして扱う視点になる。

③ 「作らない」選択肢を持つ

顧客や上司が「エージェントが欲しい」と言っても、課題解決にルールベースが最適ならそれを提案するし、RPAで事足りる場面ではそれを提案する。それが結果としてプロジェクトの成功と信頼に繋がります。

加えて、AI活用を進める事による副作用、例えばVibe Codingなどによって十分に人の目でレビューされていない品質の低いコードが出回ることで生まれるリスクなどは、企業内の仕組みによって適切な運用により防止するような取り組みが求められていくと思われます。

よってこれからは、業務にAIをどうやって導入し、業務で有効に利用するためにどう育てていくかなど単にAIツールを売るのではなく、信頼に足る『業務インフラとしてのAI』を組み上げるエンジニアリング能力が求められていくフェーズへ移っていきそうです。

この記事をシェアする

この記事をシェアする